همافزایی اینترنت اشیا و رایانش ابری؛ راهکاری جامع برای بهینهسازی عملکرد هیبرید

همافزایی اینترنت اشیا و رایانش ابری؛ راهکاری جامع برای بهینهسازی عملکرد هیبرید

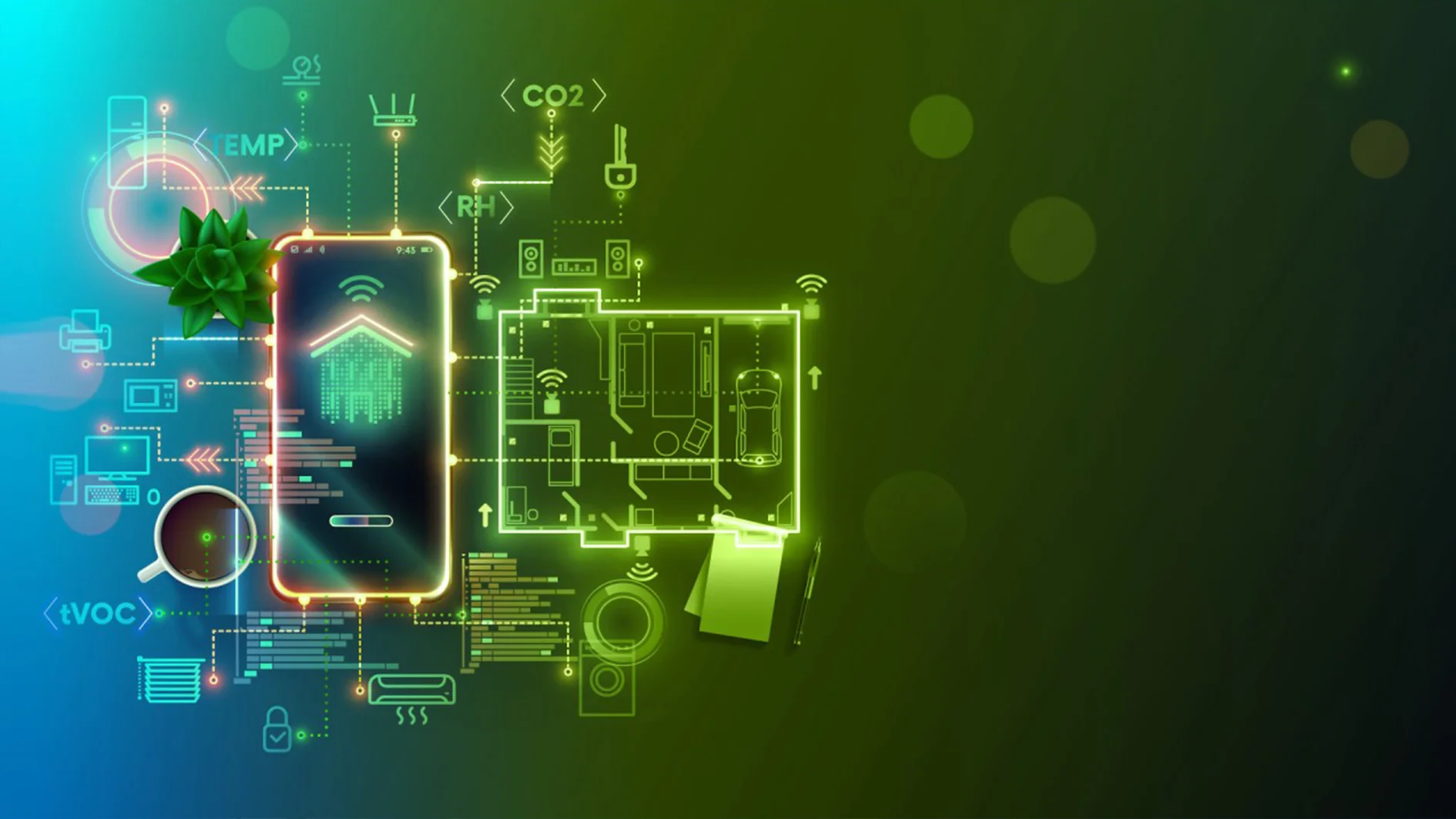

در دنیای دیجیتال امروز، ما شاهد همگرایی دو فناوری انقلابی هستیم که هر کدام به تنهایی پارادایمهای تکنولوژی را تغییر دادهاند: اینترنت اشیا (IoT) و رایانش ابری (Cloud Computing). اینترنت اشیا با اتصال میلیاردها دستگاه به شبکه جهانی، حجم عظیمی از دادهها را تولید میکند که برای استخراج ارزش و بینش، نیازمند پردازش و تحلیل هستند. از سوی دیگر، رایانش ابری با ارائه منابع پردازشی و ذخیرهسازی نامحدود و مقیاسپذیر، بستر مناسبی برای مدیریت این دادهها فراهم میآورد.

با این حال، تکیه صرف به ابر برای تمامی پردازشهای IoT چالشهایی مانند تاخیر (Latency) و مصرف پهنای باند را به همراه دارد. اینجاست که مفهوم «عملکرد هیبرید» و ادغام هوشمندانه این دو فناوری مطرح میشود. این مطلب به بررسی عمیق و جامع نحوه ادغام IoT با کلود، معماریهای مربوطه، چالشها و راهکارهای بهینهسازی عملکرد در سیستمهای هیبریدی میپردازد.

مبانی و ضرورت ادغام اینترنت اشیا و رایانش ابری

اینترنت اشیا شبکهای از دستگاههای فیزیکی است که با حسگرها و نرمافزارها تجهیز شدهاند تا دادهها را جمعآوری و تبادل کنند. این دستگاهها معمولا منابع پردازشی و باتری محدودی دارند. در مقابل، رایانش ابری منابع عظیمی را در اختیار دارد اما معمولا در مراکز دادهای متمرکز و دور از لبه شبکه (Edge) قرار گرفته است.

ادغام این دو فناوری، محدودیتهای هر یک را با نقاط قوت دیگری پوشش میدهد. ابر میتواند قدرت پردازشی و فضای ذخیرهسازی نامحدود را برای دستگاههای محدود IoT فراهم کند و دستگاههای IoT میتوانند به عنوان نقاط پایانی هوشمند برای سرویسهای ابری عمل کنند. این همزیستی، امکان پیادهسازی سناریوهای پیچیدهای مانند شهرهای هوشمند، کشاورزی دقیق و سلامت دیجیتال را فراهم میکند که در آنها نیاز به تحلیلهای بلادرنگ و همچنین تحلیلهای بلندمدت (Historical Analysis) وجود دارد.

معماریهای ادغام: از لبه تا ابر

برای درک چگونگی بهینهسازی عملکرد هیبرید، ابتدا باید معماری لایهای این سیستمها را بشناسیم. یک معماری استاندارد IoT-Cloud معمولا از سه لایه اصلی تشکیل شده است:

لایه دستگاه و حسگر (Device Layer)

این لایه شامل اشیای فیزیکی است که دادهها را تولید میکنند. این دستگاهها میتوانند از حسگرهای ساده دما تا بازوهای رباتیک پیچیده در خطوط تولید باشند. وظیفه اصلی این لایه، جمعآوری داده و ارسال آن به لایههای بالاتر است.

لایه محاسبات لبه و مه (Edge/Fog Computing Layer)

این لایه حیاتیترین بخش برای بهینهسازی عملکرد هیبرید است. محاسبات لبه یا Edge Computing، پردازش را به منبع تولید داده نزدیک میکند. در این لایه، دادهها پیش از ارسال به ابر، فیلتر، فشرده و تحلیل اولیه میشوند. در سناریوهایی که نیاز به پاسخگویی آنی وجود دارد (مانند ترمز اضطراری در خودروهای خودران)، تصمیمگیری در همین لایه انجام میشود.

برای پیادهسازی این لایه در پروژههای متوسط تا بزرگ، مهندسان شبکه معمولا از تجهیزاتی استفاده میکنند که نقش دروازه (Gateway) را ایفا کنند. گاهی اوقات برای مدیریت ترافیک سنگین دادهها پیش از ارسال به هسته مرکزی و انجام پردازشهای میانی سنگینتر که از عهده میکروکنترلرها خارج است، استفاده از یک VPS مناسب برای اینترنت اشیا و رایانش ابری در نزدیکی موقعیت جغرافیایی کاربران میتواند به عنوان یک لایه میانی موثر عمل کرده و بار پردازشی را متعادل کند. این کار باعث میشود تنها دادههای ارزشمند به ابر منتقل شوند و پهنای باند شبکه بیهوده اشغال نشود.

لایه ابری (Cloud Layer)

لایه ابری وظیفه ذخیرهسازی بلندمدت، تحلیلهای کلان داده (Big Data Analytics)، یادگیری ماشین (Machine Learning) و مدیریت کلی سیستم را بر عهده دارد. در اینجا دادههای جمعآوری شده از هزاران دستگاه در مکانهای مختلف تجمیع شده و الگوهای پیچیده شناسایی میشوند.

چالشهای فنی در سیستمهای هیبرید

اگرچه ادغام اینترنت اشیا و کلود مزایای فراوانی دارد، اما چالشهای فنی متعددی نیز در مسیر پیادهسازی آن وجود دارد که باید برطرف شوند.

مدیریت حجم عظیم دادهها (Volume)

حجم دادههای تولید شده توسط دستگاههای IoT میتواند سرسامآور باشد. انتقال تمام این دادهها به ابر نه تنها هزینه بالایی دارد، بلکه باعث اشباع پهنای باند میشود. استراتژیهای فشردهسازی و فیلترینگ داده در لبه شبکه برای حل این مشکل ضروری است.

تاخیر شبکه (Latency)

در کاربردهای حساس به زمان، تاخیر ناشی از ارسال داده به ابر و دریافت پاسخ میتواند خطرناک باشد. نوسانات شبکه اینترنت نیز بر این تاخیر تاثیر میگذارد. معماری هیبرید باید به گونهای طراحی شود که عملیات حیاتی حتی در صورت قطع ارتباط با ابر، در لایه لبه ادامه یابد.

امنیت و حریم خصوصی

با افزایش نقاط اتصال، سطح حمله (Attack Surface) گستردهتر میشود. دادهها در حال انتقال بین دستگاه، لبه و ابر باید رمزنگاری شوند. همچنین احراز هویت دستگاهها برای جلوگیری از ورود دستگاههای مخرب به شبکه الزامی است.

راهکارهای بهینهسازی عملکرد هیبرید

برای دستیابی به یک سیستم کارآمد که هم از مزایای پردازش محلی و هم از قدرت ابر بهرهمند شود، باید تکنیکهای بهینهسازی خاصی را به کار گرفت.

تقسیم هوشمند وظایف (Task Offloading)

یکی از کلیدیترین استراتژیها، تقسیم دینامیک وظایف بین لبه و ابر است. الگوریتمهای هوشمند باید تصمیم بگیرند که کدام پردازش در لبه انجام شود و کدام به ابر فرستاده شود. برای مثال، تشخیص چهره اولیه میتواند در دوربین (لبه) انجام شود، اما تطبیق چهره با یک پایگاه داده میلیونی باید در ابر صورت گیرد.

استفاده از پروتکلهای ارتباطی سبک

پروتکلهای سنتی وب مانند HTTP برای بسیاری از کاربردهای اینترنت اشیا، سنگین هستند. استفاده از پروتکلهای سبک مانند MQTT (Message Queuing Telemetry Transport) یا CoAP (Constrained Application Protocol) سربار ارتباطی را به شدت کاهش میدهد و برای شبکههای ناپایدار مناسبتر است. این پروتکلها برای ارسال پیامهای کوچک با کمترین مصرف انرژی طراحی شدهاند.

کانتینریزاسیون و میکروسرویسها

استفاده از معماری میکروسرویس و کانتینرها (مانند Docker) امکان جابجایی آسان نرمافزارها بین ابر و لبه را فراهم میکند. این رویکرد به توسعهدهندگان اجازه میدهد تا کدهای یکسانی را بنویسند و آنها را بسته به نیاز روی سرورهای ابری یا دروازههای لبه مستقر کنند.

در انتخاب زیرساخت مناسب برای ذخیرهسازی حجم عظیم دادههای سنسورها و میزبانی میکروسرویسهای مرکزی، پایداری و امنیت اولویت دارد و سرویسدهندگانی مانند سرور ابری سرور.آیآر میتوانند بستری مطمئن و با کیفیت برای مقیاسپذیری این پروژهها و اطمینان از دسترسی همیشگی به دادهها فراهم کنند. انتخاب زیرساخت صحیح مستقیما بر قابلیت اطمینان (Reliability) کل اکوسیستم تاثیر میگذارد.

نقش هوش مصنوعی و یادگیری ماشین (AIoT)

ترکیب هوش مصنوعی با اینترنت اشیا (AIoT) گام بعدی در تکامل سیستمهای هیبرید است. در این مدل، مدلهای یادگیری ماشین در کلاسترهایی از سرور GPU آموزش میبینند (Training) زیرا این فرآیند نیاز به قدرت پردازشی بالا دارد. سپس مدلهای آموزشدیده فشردهسازی شده و برای استنتاج (Inference) به لایه لبه منتقل میشوند.

این چرخه مداوم یادگیری و اجرا، سیستم را قادر میسازد تا به مرور زمان هوشمندتر شود. مثلا در یک کارخانه هوشمند، سیستم ابری الگوهای خرابی دستگاهها را از دادههای تاریخی یاد میگیرد و مدل پیشبینی را به کنترلرهای خط تولید ارسال میکند تا قبل از وقوع خرابی، هشدار دهند.

مدیریت داده و چرخه حیات اطلاعات

در یک سیستم هیبرید بهینه، همه دادهها ارزش یکسانی ندارند. پیادهسازی سیاستهای چرخه حیات داده (Data Lifecycle Management) حیاتی است.

- دادههای گرم (Hot Data): دادههایی که نیاز به پردازش آنی دارند و معمولا در لبه شبکه یا حافظه کش (Cache) پردازش میشوند.

- دادههای سرد (Cold Data): دادههایی که برای آرشیو و تحلیلهای بلندمدت نگهداری میشوند و باید به ذخیرهسازهای ارزانتر و کندتر ابری (مانند Object Storage) منتقل شوند.

تفکیک این دادهها هزینههای ذخیرهسازی را کاهش داده و سرعت دسترسی به اطلاعات حیاتی را افزایش میدهد.

اهمیت استانداردسازی و تعاملپذیری

یکی از موانع بزرگ در اینترنت اشیا، تنوع شدید دستگاهها و پروتکلهاست. برای اینکه سیستمهای هیبرید عملکرد روانی داشته باشند، نیاز به لایههای میانافزار (Middleware) است که زبانهای مختلف دستگاهها را ترجمه کرده و به یک فرمت استاندارد (مانند JSON) برای ارسال به ابر تبدیل کنند. پلتفرمهای اینترنت اشیا مدرن این قابلیت را به صورت پیشفرض ارائه میدهند تا توسعهدهندگان درگیر پیچیدگیهای سختافزاری نشوند.

آینده سیستمهای هیبرید IoT و Cloud

با ورود فناوری 5G، مرز بین لبه و ابر کمرنگتر خواهد شد. سرعت بالا و تاخیر بسیار پایین 5G امکان میدهد که حتی پردازشهای سنگین ابری نیز برای کاربر حس «در لحظه بودن» را تداعی کند. همچنین، مفهوم «هوش مصنوعی توزیعشده» (Distributed AI) که در آن چندین دستگاه لبه با همکاری یکدیگر و بدون نیاز مداوم به ابر مرکزی یک مسئله را حل میکنند، در حال رشد است.

رایانش بدون سرور (Serverless Computing) نیز مدل دیگری است که به شدت در حال نفوذ به این حوزه است. در این مدل، توسعهدهندگان تنها کد توابع (Functions) را مینویسند که در پاسخ به رخدادهای IoT (مانند تغییر دما) اجرا میشوند و نیازی به مدیریت سرورها ندارند. این امر مقیاسپذیری خودکار و کاهش هزینهها را به دنبال دارد.

ابزارهای ارکستراسیون و استقرار در لبه (Edge Deployment and Orchestration)

در محیطهای هیبرید اینترنت اشیا، مدیریت و بهروزرسانی هزاران دستگاه توزیع شده در نقاط جغرافیایی مختلف، نیازمند مکانیزمهای خودکار و قابل اعتماد است. ارکستراسیون (Orchestration) در این زمینه به معنای مدیریت و هماهنگسازی خودکار استقرار، مقیاسدهی و شبکهبندی کانتینرها و سرویسها در لایه لبه است. بدون ابزارهای ارکستراسیون، هر بهروزرسانی، وصله امنیتی یا تغییر پیکربندی باید به صورت دستی و تک به تک روی هر گره لبه اعمال شود که این کار در مقیاس بزرگ عملا غیرممکن است و همچنین ریسک خطای انسانی را به شدت بالا میبرد.

کانتینرها در لبه: Docker و K3s

سیستمهای هیبرید اینترنت اشیا برای بهینهسازی عملکرد، نیاز به استقرار سریع، امن و مدیریت متمرکز نرمافزارها در هزاران گره لبه دارند. کانتینرسازی (Containerization) که عملا توسط داکر (Docker) محبوب شد، این امکان را فراهم میکند که نرمافزارها به همراه تمام وابستگیهایشان در یک بسته سبک اجرا شوند. این بستهها میتوانند به سادگی بین ابر مرکزی و دروازههای لبه جابهجا شوند و تضمین میکنند که محیط اجرایی برنامه در هر دو فضا یکسان است و خطاهای ناشی از تفاوت محیط از بین میرود.

با این حال، مدیریت کانتینرهای متعدد روی دستگاههای لبه که منابع محدودی دارند، نیازمند ابزاری قویتر است. در اینجا، Kubernetes که سیستم ارکستراسیون پیشرو در فضای ابری است، وارد میدان میشود. البته لازم به ذکر است که برای محیط لبه، اغلب از نسخههای سبکتر آن مانند K3s یا MicroK8s استفاده میشود. این ارکستراتورها به مدیران سیستم اجازه میدهند تا صدها کانتینر را به صورت همزمان، امن و خودکار روی لبه استقرار داده، مانیتور و بهروزرسانی کنند. این معماری تضمین میکند که حتی در صورت قطع ارتباط با ابر، کانتینرهای لبه همچنان در حال اجرا و ارائه سرویسهای حیاتی باشند. در نهایت، توانایی ارکستراسیون در لبه، قابلیت «بقا» (Survivability) سیستم را در برابر قطعیهای شبکه به طرز چشمگیری افزایش میدهد.

مدیریت هزینه و بهینهسازی مالی (FinOps در IoT)

یکی از بزرگترین چالشهای عملیاتی پروژههای مقیاسپذیر IoT-Cloud، مدیریت هزینههای پنهان است. مفهوم FinOps (عملیات مالی) رویکردی سیستمی برای شفافسازی و بهینهسازی مستمر هزینههای ابری است و شامل تیمی از مهندسان، متخصصان مالی و مدیران محصول میشود. در محیط هیبرید، هزینهها پیچیدهتر هستند زیرا بین سختافزار لبه و منابع ابری توزیع شدهاند.

۱. هزینههای انتقال داده (Ingress/Egress Costs)

بیشترین هزینه پنهان مربوط به پهنای باند و انتقال داده از لبه به ابر و بالعکس (Egress) است. بهینهسازی در این بخش عملا به معنای فیلترینگ تهاجمی دادهها در لبه است. تنها دادههایی که واقعا برای تحلیل بلندمدت یا آموزش مدل ضروری هستند، باید منتقل شوند. استفاده از الگوریتمهای فشردهسازی و تجمیع دادهها در دروازههای لبه (مانند فشردهسازی مبتنی بر زمان یا رویداد) تاثیر مستقیمی بر کاهش این هزینهها دارد.

۲. هزینههای محاسباتی لبه

اگرچه پردازش در لبه برای کاهش تاخیر ضروری است، سختافزار لبه خود هزینه سرمایهگذاری اولیه (Capex) و نگهداری (Opex) دارد. برای بهینهسازی، باید از سختافزارهایی با اندازه مناسب (Right-Sizing) استفاده شود و از تکنیکهایی مانند مجازیسازی سبک و کانتینرها برای استفاده حداکثری از منابع محدود سختافزاری استفاده کرد. خاموش کردن یا قرار دادن دستگاههای غیرفعال در حالت کممصرف، به ویژه در دستگاههای باتریدار، یک استراتژی موثر است.

ملاحظات قانونی و انطباقپذیری (Compliance)

در سطح جهانی، استانداردهای قانونی سختگیرانهای برای دادههای جمعآوریشده توسط سیستمهای مجهز به اینترنت اشیا وجود دارد. در سیستمهای هیبرید، انطباقپذیری به دلیل توزیع دادهها بین مناطق محلی و سرورهای مرکزی، پیچیدهتر میشود.

قوانین حریم خصوصی (مانند GDPR)

قانون GDPR اتحادیه اروپا و قوانین مشابه در سایر نقاط جهان، بر این تاکید دارند که دادههای شخصی باید در منطقه جغرافیایی خاصی پردازش و ذخیره شوند. در معماری هیبرید، این موضوع بدین معنی است که دادههای حساس شخصی باید در لایه لبه ناشناسسازی (Anonymization) یا مستعارسازی (Pseudonymization) شوند یا تنها در مراکز داده خصوصی (Private Cloud) که تحت نظارت قانونی قرار دارند، نگهداری شوند. این امر مستلزم تفکیک دقیق دادهها در سطح دروازههای لبه پیش از ارسال به ابر عمومی است.

استانداردسازی صنعتی و ممیزی (Auditing)

در صنایعی مانند بهداشت و درمان (HIPAA در آمریکا) یا خدمات مالی، مسیر حرکت دادهها، مکان ذخیره و وضعیت دستگاهها باید کاملا قابل ممیزی باشد. استفاده از فناوری بلاکچین یا دفاتر کل توزیعشده (Distributed Ledgers) در لایه ابری میتواند شفافیت لازم را برای ممیزیهای قانونی فراهم کند و تایید کند که دادهها هرگز دستکاری نشدهاند. این قابلیت بهویژه در زنجیره تامین و لجستیک که ردیابی محصول حیاتی است، اهمیت دارد.

جمع بندی : اینترنت اشیا و پردازش ابری، آینده تمام ابزارهای مورد استفاده جامعه بشری

ادغام اینترنت اشیا با رایانش ابری دیگر یک انتخاب نیست، بلکه یک ضرورت برای معماری سیستمهای مدرن محسوب میشود. مدل هیبرید که ترکیبی از پردازش در لبه و قدرت مرکزی ابر است، راهکاری متعادل برای غلبه بر چالشهای تاخیر، پهنای باند و هزینههای پردازشی ارائه میدهد. با پیادهسازی صحیح معماری چندلایه، استفاده از پروتکلهای بهینه و بهرهگیری از هوش مصنوعی، سازمانها میتوانند به سطحی از کارایی و هوشمندی دست یابند که پیش از این ممکن نبود. موفقیت در این مسیر نیازمند درک عمیق از هر دو فناوری و انتخاب استراتژیهایی است که امنیت، مقیاسپذیری و پایداری را در اولویت قرار دهند.

سوالات متداول

رایانش ابری بر پردازش متمرکز دادهها در دیتاسنترهای بزرگ تمرکز دارد که قدرت پردازشی بالا اما تاخیر بیشتری دارند. در مقابل، رایانش لبه پردازش را در نزدیکی منبع تولید داده (مثل سنسورها یا دروازهها) انجام میدهد که باعث کاهش تاخیر و مصرف پهنای باند میشود اما قدرت پردازشی محدودتری دارد. بهترین عملکرد از ترکیب این دو حاصل میشود.

اتصال دستگاههای بیشتر قطعا سطح حمله را افزایش میدهد، اما ادغام صحیح با کلود میتواند امنیت را بهبود بخشد. سرویسهای ابری معمولا پروتکلهای امنیتی پیشرفته، بهروزرسانیهای خودکار و ابزارهای مانیتورینگ تهدیدات را ارائه میدهند که پیادهسازی آنها به صورت جداگانه برای هر دستگاه اینترنت اشیا، دشوار است. با این حال، رمزنگاری نقطه به نقطه (End-to-End) و پیادهسازی معماری اعتماد صفر ضروری است.

پروتکل MQTT یک استاندارد پیامرسانی سبک است که برای دستگاههایی با منابع محدود و شبکههای ناپایدار طراحی شده است. محبوبیت آن به دلیل سربار (Overhead) بسیار کم، مصرف پایین انرژی و مدل انتشار/اشتراک آن است که مدیریت ارتباط بین هزاران دستگاه را ساده میکند.

همزاد دیجیتال نسخه مجازی یک دستگاه یا سیستم فیزیکی است که در محیط ابری شبیهسازی میشود. این مدل با دریافت دادههای واقعی از سنسورها، وضعیت لحظهای دستگاه را نشان میدهد و به مهندسان اجازه میدهد بدون متوقف کردن دستگاه واقعی، تعمیرات را پیشبینی کنند یا سناریوهای مختلف را تست کنند.

بهترین راهکار استفاده از سیاستهای چرخه حیات داده است. تنها دادههای خلاصه شده و مهم به ابر ارسال شوند (پیشپردازش در لبه) و دادههای قدیمیتر که کاربرد لحظهای ندارند به سرویسهای ذخیرهسازی سرد (Cold Storage) که هزینه بسیار کمتری دارند، منتقل شوند.

در یادگیری فدرال، به جای اینکه دادههای خصوصی کاربران به سرور مرکزی ارسال شود، مدل هوش مصنوعی به دستگاه کاربر فرستاده شده و همانجا آموزش میبیند. تنها نتایج ریاضی حاصل از یادگیری به سرور برمیگردد. این یعنی دادههای خام هرگز از دستگاه خارج نمیشوند.

شما میتوانید دیدگاه خود را در مورد این مطلب با ما با اشتراک بگذارید.