زیرساخت مورد نیاز برای اجرای مدلهای هوش مصنوعی چیست؟

زیرساخت مورد نیاز برای اجرای مدلهای هوش مصنوعی چیست؟

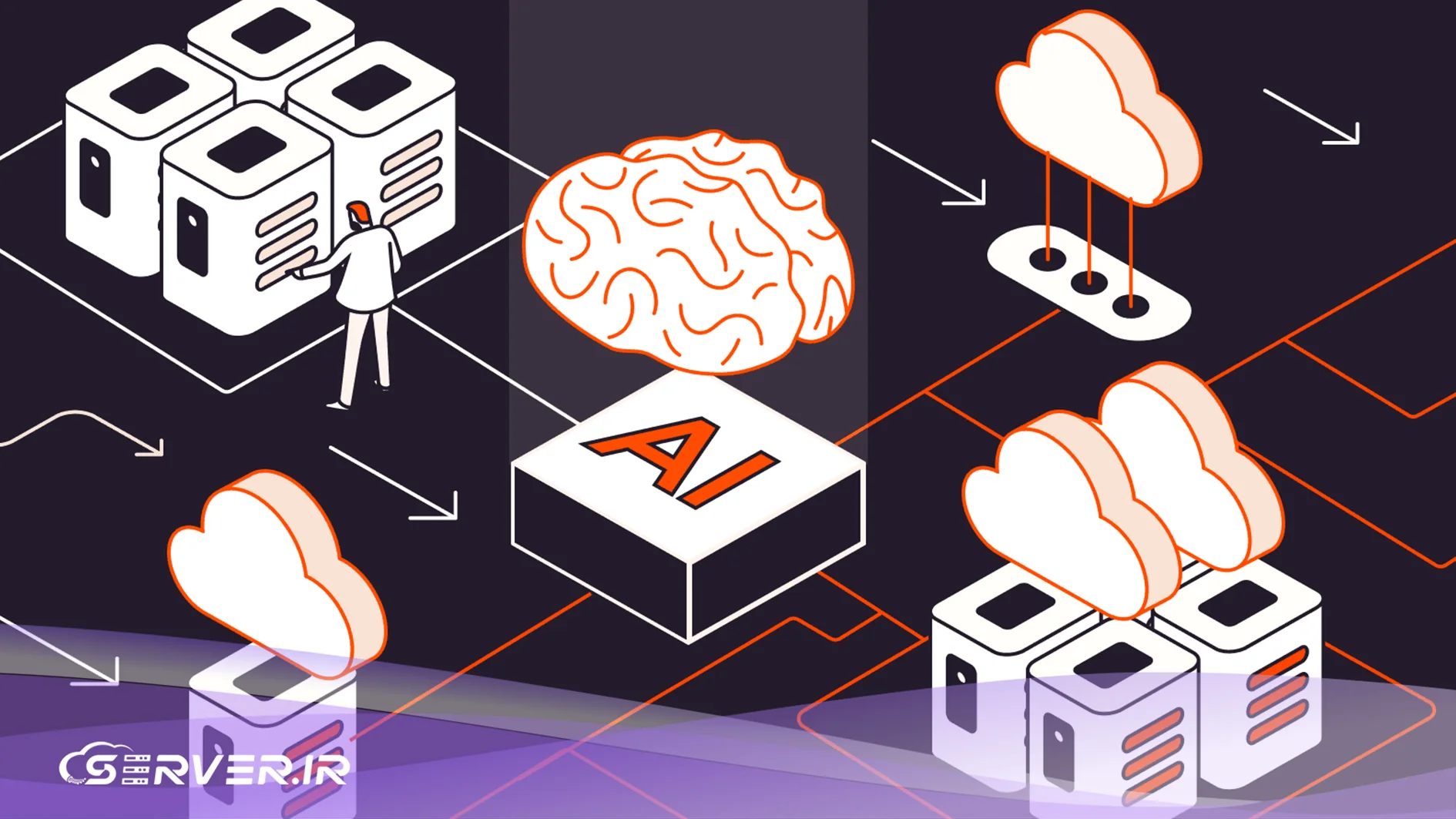

در دهههای اخیر، هوش مصنوعی (AI) از یک مفهوم علمی تخیلی به یک نیروی محرک اصلی در تمامی صنایع تبدیل شده است. از مدلهای زبانی بزرگ (LLM) مانند GPT تا سیستمهای پیچیده بینایی کامپیوتر که خودروهای خودران را هدایت میکنند، همه چیز مبتنی بر قدرت مدلهای یادگیری ماشین و یادگیری عمیق است. با این حال، شاهکار ساخت یک مدل هوشمند تنها به نبوغ کدنویسی و الگوریتمهای پیشرفته محدود نمیشود؛ این مدلها برای نفس کشیدن و عمل کردن نیازمند ریههای قدرتمندی به نام زیرساخت سختافزاری هستند.

اجرای موفقیتآمیز، آموزش و استقرار این مدلها، به ویژه در مقیاسهای صنعتی و سازمانی، نیازمند تصمیمگیری استراتژیک در مورد نوع منابع است.

چرا اجرای مدلهای هوش مصنوعی به زیرساخت قدرتمند نیاز دارد؟

ماهیت مدلهای یادگیری عمیق، پردازش حجم عظیمی از دادهها و انجام محاسبات ماتریسی در لحظه است که به منابع سختافزاری بالایی نیاز دارد:

- حجم عظیم دادهها و پردازشهای ماتریسی: در زمان آموزش، مدل باید میلیونها یا میلیاردها پارامتر را بهطور مکرر از طریق مجموعه دادههای بزرگ تنظیم کند. این فرایند به معنای اجرای موازی و بسیار سریع ضرب ماتریسها است.

- فشار زیاد روی CPU، GPU و RAM: آموزش مدلها، به خصوص شبکههای عصبی پیچیده، فشار محاسباتی بیسابقهای روی کارت گرافیک (GPU) وارد میکند، در حالی که پردازنده (CPU) و حافظه اصلی (RAM) نیز در مدیریت جریان دادهها و پیشپردازش اطلاعات نقش حیاتی دارند.

- نیاز به ذخیرهسازی سریع و پهنای باند بالا: دادههای آموزشی باید با سرعتی فوقالعاده بالا توسط مدل مصرف شوند تا از گلوگاه شدن GPU جلوگیری شود. از این رو، استفاده از درایوهای NVMe و SSD حیاتی است و پهنای باند شبکه برای پروژههای توزیعشده ضرورت مییابد.

مدلهای هوش مصنوعی مدرن، بهویژه مدلهای مولد (Generative Models)، با هر تکرار پیشرفت، نیازمند پارامترهای بیشتر و دادههای آموزشی گستردهتری هستند. این امر منجر به مفهوم «قانون مور هوش مصنوعی» شده است که هر چند ماه، توان محاسباتی مورد نیاز را دو تا سه برابر میکند. این رشد تصاعدی، زیرساختهایی را میطلبد که تنها به امروز پاسخ ندهند، بلکه قابلیت مقیاسپذیری سریع برای فردای پژوهش را نیز داشته باشند تا تیمها در میانه پروژه، با کمبود منابع مواجه نشوند.

یکی دیگر از دلایل کلیدی برای نیاز به سختافزار قدرتمند، بحث زمان است. در دنیای رقابتی AI، سرعت آموزش مدلها یک مزیت استراتژیک محسوب میشود. یک پروژه یادگیری عمیق که در حالت عادی با یک سختافزار ضعیف ممکن است هفتهها به طول انجامد، با استفاده از GPUهای رده بالا و پهنای باند مناسب میتواند در عرض چند روز یا حتی چند ساعت تکمیل شود. این کاهش زمان منجر به تکرار سریعتر، آزمایش فرضیههای بیشتر و در نهایت، بهینهسازی بهتر مدل میشود.

اجزای اصلی زیرساخت اجرای مدلهای هوش مصنوعی

پردازنده (CPU)

پردازنده مغز سیستم است و در اجرای وظایف موازی، مدیریت سیستمعامل، بارگذاری دادهها، پیشپردازش و هماهنگی کلی منابع نقش اساسی دارد. گرچه GPU بار محاسباتی سنگین را بر عهده میگیرد، اما انتخاب یک CPU مناسب برای جلوگیری از «گرسنگی» کشیدن GPU (کمبود داده برای پردازش) ضروری است. پردازندههای سطح سازمانی مانند Intel Xeon یا AMD EPYC به دلیل تعداد هستههای بالا، پشتیبانی از حافظه RAM بیشتر و قابلیت اطمینان، معمولا گزینههای بهتری نسبت به پردازندههای معمولی (مانند Core i7/i9) هستند.

پردازنده علاوه بر مدیریت کلی، در بسیاری از مراحل پس از آموزش نیز نقشی حیاتی ایفا میکند. به عنوان مثال، در هنگام استنتاج (Inference) برای برخی از مدلهای سادهتر یا در لایههای ابتدایی و انتهایی مدلهای بزرگتر، CPU هنوز بار محاسباتی قابل توجهی را به دوش میکشد. همچنین، زمانی که از مدلهای کوچکتر در حجم بالا استفاده میشود، عملکرد تکرشتهای قوی (Single-thread performance) CPU میتواند تاثیر مهمی بر تأخیر (Latency) سرویس نهایی داشته باشد.

کارت گرافیک (GPU)

GPU قلب تپنده زیرساخت هوش مصنوعی است. نقش اصلی آن در شتابدهی آموزش مدلها است، به ویژه در مورد ساختارهایی مانند شبکههای عصبی کانولوشنی (CNN) برای بینایی کامپیوتر یا مدلهای ترانسفورمر (Transformer) برای پردازش زبان طبیعی. معماری موازی GPU، آن را برای اجرای همزمان هزاران عملیات ضرب ماتریسی که سنگ بنای یادگیری عمیق هستند، ایدهآل میکند.

- کارتهای مخصوص دیتاسنتر: کارتهایی مانند NVIDIA A100 و H100 که برای مراکز داده طراحی شدهاند، بیشترین قدرت و پایداری را ارائه میدهند.

- کارتهای نیمهصنعتی: کارتهایی مثل NVIDIA RTX 4090 یا A4000 نیز میتوانند گزینههای مقرونبهصرفهای برای پروژههای متوسط باشند.

تیمهای زیادی که بودجه خرید سختافزارهای گرانقیمت مانند H100 را ندارند، بهطور طبیعی به سمت خرید سرور گرافیکی روی میآورند که یک راهحل اقتصادی و سریع برای دسترسی به قدرت محاسباتی بالا است.

علاوه بر مدلهای رایج، زیرساختهای گرافیکی برای فناوریهای نوظهور مانند شبیهسازیهای فیزیک دقیق که در هوش مصنوعی تقویتی (Reinforcement Learning) کاربرد دارند، ضروری است. این شبیهسازیها نیازمند رندرینگ سریع و محاسبات موازی پیچیده هستند که باز هم GPUها را به ابزاری بیبدیل تبدیل میکند. همچنین، میزان VRAM (حافظه گرافیکی) کارت گرافیک، مستقیما اندازه مدل و اندازه دستهای (Batch Size) را که میتوان در هر مرحله آموزش داد، تعیین میکند. هرچه VRAM بیشتر باشد، میتوان مدلهای بزرگتر و پیچیدهتری را بدون نیاز به تکنیکهای پیچیده توزیع حافظه، آموزش داد.

حافظه RAM

RAM تأثیر مستقیمی بر حجم دادهای دارد که میتواند بهطور همزمان پردازش شود. برای جلوگیری از جابهجایی مکرر دادهها بین RAM و دیسک (که سرعت آموزش را کاهش میدهد)، لازم است حجم RAM متناسب با اندازه مجموعه داده و اندازه مدل (Batch Size) انتخاب شود. مدلهای بسیار بزرگ و LLMها معمولا به صدها گیگابایت RAM نیاز دارند.

فضای ذخیرهسازی (Storage)

سرعت I/O (ورودی/خروجی) در پردازش دادههای حجیم حیاتی است. استفاده از SSD و بهویژه NVMe به جای هارد دیسکهای سنتی (HDD) تضمین میکند که دادهها با سرعتی کافی به GPU برسند و فرآیند آموزش دچار تأخیر نشود. NVMeها میتوانند تا چندین برابر سریعتر از SSDهای SATA باشند.

ذخیرهسازی تنها در مورد سرعت خواندن و نوشتن دادههای آموزشی نیست؛ بلکه مدیریت دادههای کلان و ایجاد «دیتا پایپلاین» کارآمد نیز اهمیت دارد. در پروژههای AI، دادهها اغلب ساختارمند نیستند و ممکن است به شکل هزاران فایل تصویری یا ویدیویی حجیم باشند. یک سیستم ذخیرهسازی خوب باید علاوه بر سرعت، قابلیت مدیریت انبوهی از فایلهای کوچک را بدون افت عملکرد داشته باشد، که این امر توسط معماریهای NVMe و تنظیمات RAID مناسب بهدست میآید.

پهنای باند و شبکه

در پروژههای پیشرفته هوش مصنوعی توزیعشده، که چندین GPU یا سرور بهطور همزمان برای آموزش یک مدل واحد به کار گرفته میشوند (مانند آموزش GPT)، سرعت انتقال داده بین نودها بسیار مهم است. استفاده از شبکههای پرسرعت اترنت (مانند 10GbE یا بالاتر) یا فناوریهایی مثل InfiniBand ضروری است.

مقایسه راهکارهای زیرساختی برای اجرای مدلهای AI

| ویژگی | VPS | اجاره سرور گرافیکی | سرور اختصاصی |

| مناسب برای | پروژههای کوچک، فازهای آزمایشی | آموزش مدلهای سنگین با بودجه محدود | پروژههای بزرگ سازمانی، LLMها، امنیت بالا |

| قدرت محاسباتی | محدود (اغلب بدون GPU اختصاصی) | بالا (دسترسی به GPUهای قدرتمند) | بسیار بالا (کنترل کامل روی سختافزار) |

| کنترل و امنیت | نسبتا پایین (محیط اشتراکی) | متوسط تا بالا | کامل (دسترسی روت و محیط ایزوله) |

| هزینه اولیه | کمترین | هزینه ساعتی/ماهانه معقول | بالاترین (نیاز به خرید سختافزار) |

تفاوت بین راهحلهای زیرساختی، در واقع تفاوت بین CAPEX (هزینههای سرمایهای) و OPEX (هزینههای عملیاتی) است. خرید یک سرور اختصاصی یک سرمایهگذاری سنگین (CAPEX) اولیه است که با کنترل کامل همراه است اما استهلاک و نگهداری دارد. در مقابل، اجاره سرور گرافیکی یا استفاده از VPS، هزینههای عملیاتی (OPEX) هستند که به تیم اجازه میدهد با انعطافپذیری مالی و بدون درگیری با چالشهای نگهداری سختافزار، مقیاسبندی کنند.

یکی از مزایای کمتر دیده شده سرور اختصاصی مناسب برای زیرساخت هوش مصنوعی، پایداری قیمت آن است. در حالی که قیمت سرویسهای ابری و اجارهای ممکن است بر اساس تقاضا و بازار تغییر کند، هزینه ماهانه اجاره یا مالکیت یک سرور ثابت است. این پایداری برای پروژههای طولانی مدت با بودجه ثابت، یک مزیت برنامهریزی مالی محسوب میشود.

استفاده از سرور اختصاصی

خرید سرور اختصاصی کنترل کامل بر روی تمامی منابع فیزیکی را فراهم میکند و برای پروژههای بزرگ، سازمانی و پایدار که نیازمند امنیت و عملکرد بینقص در طولانی مدت هستند، بهترین گزینه است. در یک سرور اختصاصی، کاربر میتواند معماری سختافزاری را بهطور کامل شخصیسازی کند تا دقیقا نیازهای مدلهای LLM یا مدلهای یادگیری عمیق خود را برآورده سازد.

اجاره سرور گرافیکی

اجاره سرور گرافیکی، کاربردیترین راهحل برای تیمهایی است که به دنبال قدرت خام GPU برای آموزش مدلهای سنگین هستند اما نمیخواهند متحمل هزینه اولیه بالا برای خرید سختافزارهای گرانقیمت شوند. امکان استفاده از چند GPU بهصورت همزمان و انعطافپذیری در مقیاسبندی منابع، آن را به یک انتخاب جذاب تبدیل کرده است.

VPS برای پروژههای کوچکتر یا تست مدلها

VPS (Virtual Private Server) که یک محیط مجازیسازی شده از یک سرور فیزیکی است، گزینهای با هزینه کمتر و انعطافپذیری بالاتر برای فازهای آزمایشی، توسعه برنامههای کاربردی مبتنی بر مدلهای هوش مصنوعی از پیش آموزشدیده، یا اجرای مدلهای سبک محسوب میشود. اگرچه سرور مجازی به دلیل اشتراکی بودن منابع و معمولا عدم دسترسی به GPU اختصاصی، محدودیتهایی در آموزش مدلهای سنگین دارد، اما شروعی عالی برای تیمهای کوچک است و همچنین راهکاری مقرون به صرفه برای اجرا و تست مدل آموزش دیده نیز به شمار میروند.

انتخاب بهترین گزینه بر اساس نوع پروژه هوش مصنوعی

انتخاب درست زیرساخت باید بر اساس مقیاس پروژه، بودجه و فاز توسعه صورت گیرد:

- پروژههای کوچک و توسعه اولیه: اگر در حال کار بر روی مدلهای سبک یا در حال آزمایش ایدههای اولیه هستید، استفاده از یک راهکار خصوصی مجازی مقرونبهصرفهترین راهکار است.

- پروژههای متوسط یا آموزش مدلهای با دیتای زیاد: برای آموزشهای مکرر و سنگین مدلهایی مانند مدلهای پردازش تصویر یا توالی، سرویسهای اجارهای GPU بهترین تعادل بین قدرت و هزینه را فراهم میکند.

- پروژههای سازمانی، مدلهای LLM و یادگیری عمیق در مقیاس بزرگ: اگر نیاز به پایداری بالا، کنترل امنیتی کامل و حداکثر عملکرد برای مدلهای مولد (Generative AI) دارید، سرورهای فیزیکی اختصاصی راهکار نهایی است.

این بخش باید دید تصمیمسازی به خواننده بدهد؛ هدف کمک به انتخاب منطقی سرویس است، نه فروش مستقیم.

نکات مهم در پیکربندی و بهینهسازی زیرساخت AI

-

انتخاب سیستمعامل و درایور مناسب: بیشتر پروژههای هوش مصنوعی بر روی لینوکس (مانند Ubuntu) اجرا میشوند. نصب درایورهای اختصاصی NVIDIA و ابزارهایی مانند CUDA و cuDNN برای تعامل کارآمد PyTorch یا TensorFlow با GPU ضروری است.

-

مانیتورینگ منابع: در زمان آموزش، باید بهطور مداوم دمای GPU، مصرف حافظه و بار CPU را با ابزارهایی مانند

nvidia-smiمانیتور کنید. -

مدیریت دما و خنکسازی: GPUها در زمان آموزش گرمای زیادی تولید میکنند. خنکسازی کافی در سرورهای اختصاصی و اتاق سرور برای حفظ عملکرد و طول عمر سختافزار حیاتی است.

-

بکاپ و امنیت دادهها: اطمینان از امنیت دادههای آموزشی و مدلهای نهایی ذخیره شده در زیرساخت، به ویژه در محیطهایی که تا حدودی منابع اشتراکی دارند، اهمیت زیادی دارد.

بهینهسازی نرمافزاری بر روی زیرساخت به همان اندازه انتخاب سختافزار مهم است. استفاده از کتابخانههایی با عملکرد بالا مانند TensorRT توسط NVIDIA برای استنتاج، میتواند سرعت مدل را بدون تغییر سختافزار تا چندین برابر افزایش دهد. این بهینهسازیها شامل تبدیل مدلهای آموزشدیده به فرمتهای سبکتر و بهینهتر برای اجرای سختافزاری است و مستقیما بر کارایی زیرساخت انتخابی تأثیر میگذارد.

امنیت زیرساخت AI شامل حفاظت از مالکیت فکری مدلهای آموزشدیده و دادههای حساس است. یک نقص امنیتی میتواند منجر به سرقت مدلهای میلیارد دلاری شود. بنابراین، جداسازی شبکه (Network Segmentation)، بهروزرسانی منظم سیستمعامل و استفاده از ابزارهای مانیتورینگ نفوذ، اجزای جداییناپذیر پیکربندی هستند.

آینده زیرساختهای هوش مصنوعی

آینده زیرساختهای AI به سرعت در حال تکامل است. ما شاهد رشد فزاینده خدمات GPU Cloud هستیم که دسترسی دموکراتیک به قدرت محاسباتی را فراهم میکنند. دیتاسنترها به سمت سرورهای پیشرفتهتر، با فناوریهای خنکسازی مایع و استفاده از سرورهای مبتنی بر هوش مصنوعی خودکار (AI-driven infrastructure) حرکت میکنند که میتوانند منابع را بهطور پویا بر اساس نیاز مدلها تنظیم کنند.

ظهور تراشههای شتابدهنده غیر-GPU مانند TPUهای گوگل یا شتابدهندههای هوش مصنوعی اختصاصی، نشان میدهد که بهینهسازی سختافزاری برای هر نوع مدل خاص مسیر جدیدی است. این تنوع در آینده، انتخاب را برای مدیران پروژه دشوارتر و در عین حال، عملکرد را به شکل چشمگیری بهتر خواهد کرد.

مدیریت زیرساخت خودکار (AI-driven infrastructure) نیز یک روند کلیدی است. این سیستمها از هوش مصنوعی برای پیشبینی نیازهای محاسباتی مدلها، تخصیص منابع بهطور خودکار، و حتی خاموش کردن خوشهها در زمان عدم فعالیت استفاده میکنند. این امر باعث بهینهسازی مصرف انرژی و کاهش هزینههای عملیاتی، بهویژه در محیطهای ابری یا دیتاسنترهای بزرگ میشود.

جمعبندی

موفقیت در پروژههای هوش مصنوعی امروزی به یک معادله پیچیده وابسته است: ترکیب الگوریتمهای نوآورانه با زیرساخت سختافزاری مناسب. برای هر مدیر فنی یا توسعهدهنده، انتخاب معماری مناسب برای اجرای مدلها یک تصمیم حیاتی است که مستقیما بر بازده سرمایهگذاری (ROI) و زمان رسیدن به بازار تاثیر میگذارد.

صرف نظر از اینکه پروژه در مرحله تست و توسعه اولیه قرار دارد یا در حال استقرار یک مدل عظیم در مقیاس سازمانی است، نیاز به قدرت پردازشی بالا، بهویژه از طریق GPUهای بهینه شده، غیرقابل انکار است. ارزیابی دقیق بین نیاز به کنترل کامل (که با سرورهای فیزیکی به دست میآید) و انعطافپذیری اقتصادی (که توسط راهحلهای اجارهای فراهم میشود)، کلید دستیابی به بالاترین سطح عملکرد و کارایی مدل هوش مصنوعی خواهد بود.

سوالات متداول

خیر، همیشه به GPU نیاز نیست. برای مدلهای یادگیری ماشین سنتیتر (مانند رگرسیون یا درخت تصمیم) یا مدلهای شبکههای عصبی بسیار کوچک، CPU معمولا کافی است. با این حال، برای مدلهای یادگیری عمیق (Deep Learning) مانند CNN، RNN، Transformer یا LLMها، GPU تقریبا ضروری است زیرا قدرت محاسباتی موازی آن برای آموزش سریع این مدلهای سنگین مورد نیاز است.

انتخاب شما به مقیاس، بودجه و نیاز به کنترل بستگی دارد:

- VPS: مناسب برای فازهای آزمایشی، استقرار مدلهای کوچک و پروژههای با بودجه محدود. هزینه کمتری دارد اما منابع آن اشتراکی و محدود است.

- سرور اختصاصی: مناسب برای پروژههای بزرگ و سازمانی، آموزش مدلهای عظیم (مانند LLM) و زمانی که به کنترل کامل منابع فیزیکی، امنیت بالا و عملکرد پایدار نیاز دارید. هزینه اولیه یا اجاره ماهانه بیشتری دارد.

VRAM تعیین میکند که مدل و دادههای آموزشی شما چقدر میتوانند بزرگ باشند. هرچه مدل شما پارامترهای بیشتری داشته باشد و یا بخواهید از اندازه دستهای (Batch Size) بزرگتری برای آموزش استفاده کنید، به VRAM بیشتری نیاز خواهید داشت. کمبود VRAM اغلب منجر به خطاهای خارج از حافظه (Out of Memory) در حین آموزش مدلهای بزرگ میشود.

بله، در دو حالت پهنای باند شبکه حیاتی است:

-

پروژههای توزیعشده: اگر برای آموزش یک مدل از چندین سرور (خوشه) بهطور همزمان استفاده میکنید، نیاز به شبکههای فوق سریع (مانند InfiniBand یا 10GbE) برای انتقال داده بین نودها دارید تا GPUها معطل نشوند.

-

بارگذاری دادهها: اگر مجموعه دادههای آموزشی شما در یک فضای ذخیرهسازی ابری یا شبکه مشترک قرار دارد، پهنای باند بالا سرعت انتقال داده به سرور آموزش را تعیین میکند.

خرید GPU (مثلا در قالب یک سرور اختصاصی) به هزینه سرمایهای (CAPEX) بالا، اما کنترل کامل و مالکیت طولانی مدت منجر میشود. اجاره سرور گرافیکی (GPU Rental) یک هزینه عملیاتی (OPEX) است. این روش به شما امکان دسترسی سریع و انعطافپذیر به جدیدترین و گرانترین GPUها (مانند A100 یا H100) را میدهد و هزینه اولیه را کاهش میدهد، اما مالکیت یا کنترل مستقیم بر سختافزار را ندارید.

شما میتوانید دیدگاه خود را در مورد این مطلب با ما با اشتراک بگذارید.