خزنده وب یا Web Crawler

یک خزنده وب یا web crawler، نقش بارگیری و رتبهبندی محتوا از شبکه اینترنت را ایفا مینماید. از نامهای دیگر یک خزنده میتوان به spider و بات موتور جستجو نیز اشاره کرد. وظیفه این بات یادگیری این نکته است که هر صفحه در شبکه چه موضوعی دارد تا اطلاعات جمعآوری شده در وقت مناسب فراخوانی گردیده و مورد استفاده قرار گیرند. دلیل نامگذاری باتهای موتورهای جستجو به شکل خزنده وب این حقیقت میباشد که واژه خزیدن لفظ تکنیکال برای دسترسی خودکار به یک وبسایت و جمعآوری دادهها توسط یک برنامه نوشته شده میباشد.

باتهای خزنده وب در غالب مواقع توسط موتورهای جستجو ایجاد و اجرا میشوند. موتورهای جستجو با اعمال یک الگوریتم جستجو بر اطلاعات گردآوری شده، قابلیت نمایش لینکهای مرتبط را در پاسخ به عبارت جستجو شده توسط یک کاربر دارند.

خزندههای وب چگونه کار میکنند؟

یک بات خزنده وب را میتوان به شخصی در یک کتابخانه بسیار بزگ تشبیه نمود که وظیفه دسته بندی و ثبت موضوع هر کتاب را داراست تا به این ترتیب مراجعین قادر باشند در اسرع وقت اطلاعات مورد نظر خود را پیدا کنند. برای سازماندهی دقیق کتابها، شخص کتابدار نیاز دارد تا عنوان، خلاصه و مقداری از محتوای آنها را بررسی نماید.

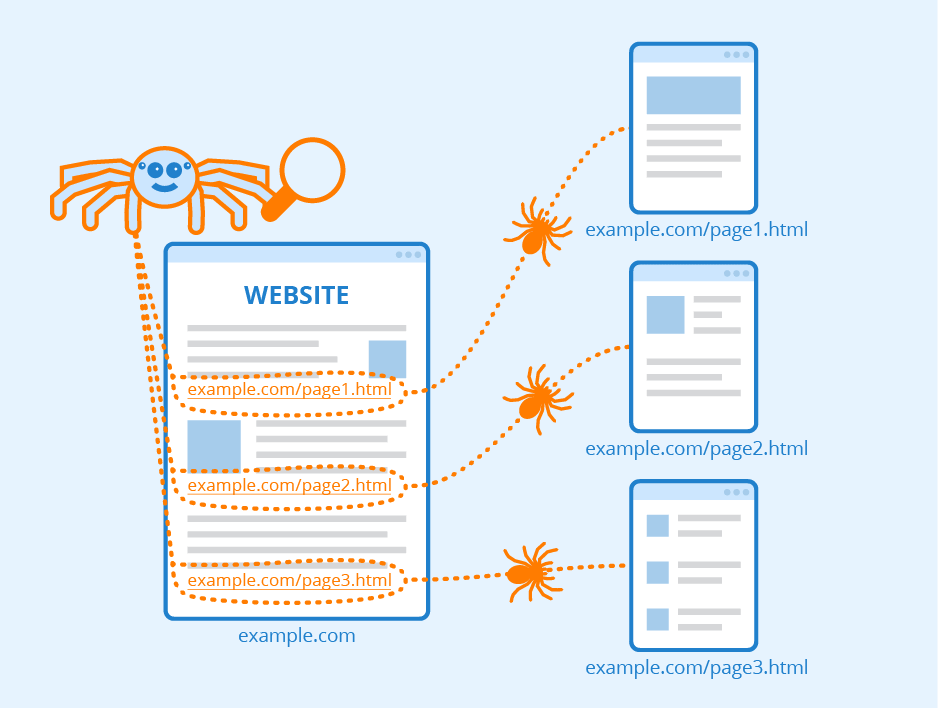

تفاوت اصلی آنجایی است که صفحات وب برخلاف کتابها ماهیتی مجازی دارند و به همین دلیل حصول اطمینان از بررسی کامل آنها امری غیرممکن میباشد. برآوردها نشان میدهند تنها چیزی در حدود 70 درصد از محتوای موجود در اینترنت مورد رتبهبندی قرار میگیرد که این خود شامل میلیاردها صفحه میشود. البته این مجازی بودن محیط مزیتی نیز در نحوه یافتن صفحات مرتبط با یکدیگر دارد. یک خزنده وب معمولا به صفحات شناخته شده تر شروع میکند و سپس از طریق هایپرلینکهای موجود در آن صفحات به صفحاتی با محتوای مشابه رفته و این روند را به صورت متعدد تکرار مینماید. اما با توجه به گستردگی فضای اینترنت، این فرآیند ممکن است به یک چرخه بینهایت تبدیل گردد و به همین دلیل نیز خزندههای وب سیاستهای خاصی را در خصوص اینکه چه صفحاتی را بررسی و رتبه بندی نمایند اجرا میکنند.

برخی موارد رعایت شده توسط یک خزنده وب

- اهمیت نسبی هر صفحه: غالب خزندهها تمامی اطلاعات موجود بر بستر اینترنت را مورد بررسی قرار نمیدهند و به جای این کار ترجیح میدهند ابتدا صفحات را بر مبنای مواردی همچون تعداد لینکهایی که از صفحات دیگر به آنها زده شده است و میزان بازدیدکنندگان بررسی نمایند. دلیل این امر آن است که صفحهای که به میزان بالا مشاهده و یا از صفحات دیگر به آن ارجاع داده شده است، قطعا دارای اطلاعات با کیفیت و مرتبط با کلمات مورد جستجو خواهد بود.

- بازدید صفحات به صورت مستمر: محتوای اینترنت به طور دائم در حال به روزرسانی، حذف و یا جا به جا شدن میباشد. به همین علت خزندههای وب نیاز دارند تا به صورت دورهای صفحات را بررسی کنند تا در جریان تغییرات محتوای آنها قرار گیرند.

- فایل Robots.txt: خزندههای وب پیش از بررسی یک صفحه، فایل Robots.txt میزبانی شده توسط وب سرور آن وبسایت را چک میکنند. این فایل قوانین و سطوح دسترسی را برای باتهای مراجعه کننده به صفحات تعیین مینماید.

شما میتوانید دیدگاه خود را در مورد این مطلب با ما با اشتراک بگذارید.