یادگیری عمیق (Deep Learning) چیست؟ راهنمای جامع

یادگیری عمیق یا Deep Learning که اختصارا DL نامیده میشود، زیرمجموعهای از یادگیری ماشین (Machine Learning) است که خود، بخشی از هوش مصنوعی (Artificial Intelligence) به شمار میرود. ایده اصلی یادگیری عمیق تقلید از ساختار و عملکرد مغز انسان برای پردازش دادهها، ایجاد الگوها جهت استفاده در تصمیمگیری و درک است. این حوزه به کامپیوترها اجازه میدهد تا با استفاده از شبکههای عصبی مصنوعی که از چندین لایه تشکیل شدهاند، مفاهیم پیچیده را مستقیما از دادههای خام (مانند تصاویر، متون و صدا) بیاموزند و استخراج ویژگیها را به صورت خودکار انجام دهند.

تعریف یادگیری عمیق (Deep Learning) و تفاوت آن با یادگیری ماشین

در روشهای سنتی یادگیری ماشین، مهندسان باید وقت زیادی را صرف «مهندسی ویژگی» (Feature Engineering) میکردند؛ یعنی به صورت دستی ویژگیهای مرتبط را از داده استخراج میکردند تا مدل بتواند یاد بگیرد. در مقابل، یادگیری عمیق این فرآیند را کاملا متحول کرده است.

تفاوت کلیدی:

- یادگیری ماشین سنتی: نیازمند ورودی ویژگیهای استخراجشده دستی است. مثلا برای تشخیص چهره، باید به صورت دستی ویژگیهایی مثل لبهها یا زوایا را تعریف کرد.

- یادگیری عمیق (DL): با تکیه بر ساختار چندلایهای، خود مدل به صورت سلسله مراتبی ویژگیهای مرتبط را یاد میگیرد. مثلا در لایههای ابتدایی خطوط و لبهها، و در لایههای عمیقتر مفاهیم پیچیدهتری مانند چشم یا بینی را میآموزد. این قابلیت باعث شده تا DL در مسائلی که دارای ابعاد دادهای بالا و پیچیدگی زیاد هستند، بسیار تاثیرگذار باشد.

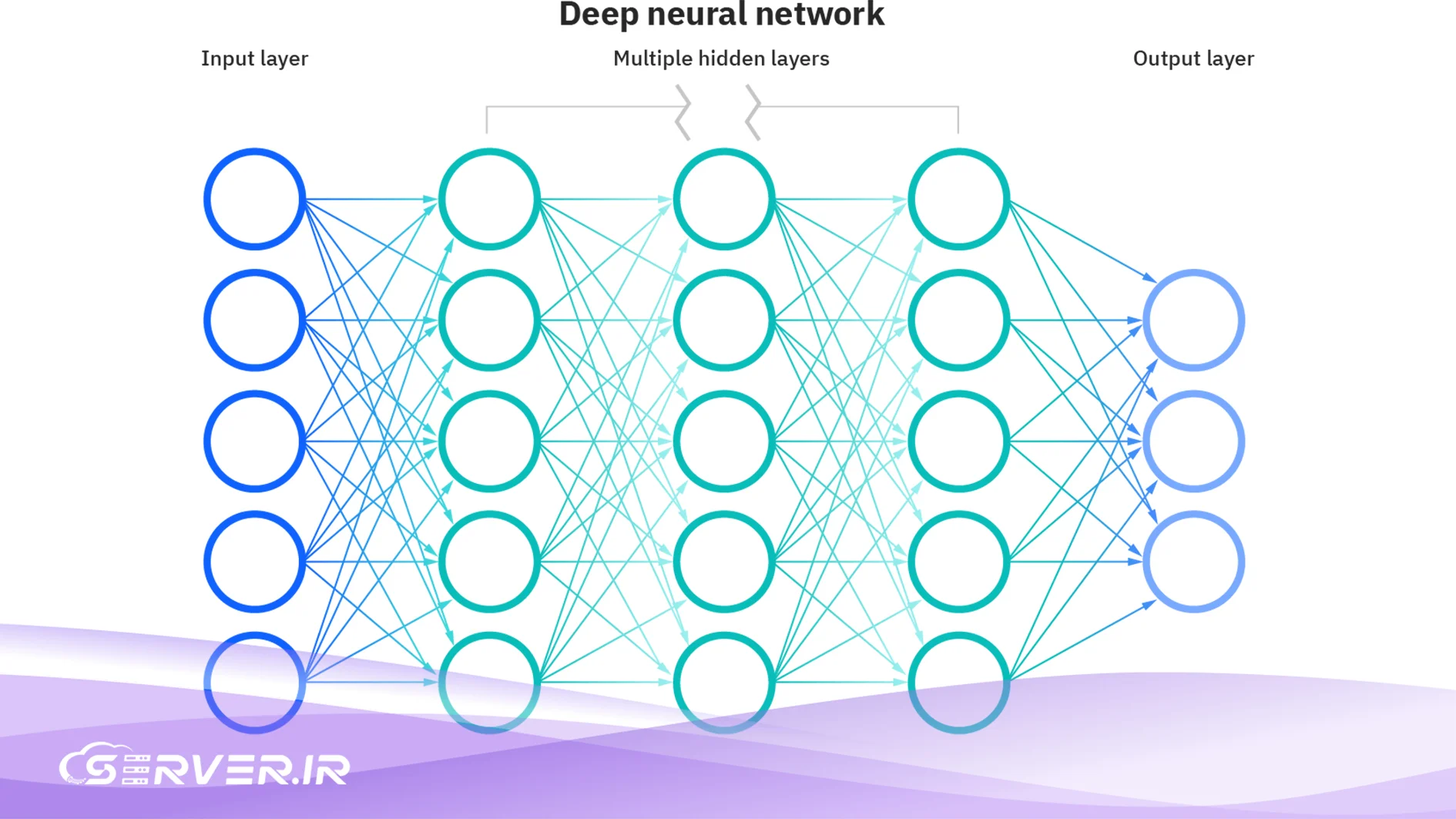

ساختار شبکههای عصبی عمیق

مفهوم «عمیق» در یادگیری عمیق، به تعداد لایههای پنهان (Hidden Layers) در شبکه عصبی اشاره دارد. یک شبکه عصبی عمیق دارای چندین لایه پنهان است که هر کدام وظیفه یادگیری یک سطح انتزاعی از دادهها را بر عهده دارند.

لایههای ورودی، پنهان و خروجی

هر شبکه عصبی از سه نوع لایه اصلی تشکیل شده است:

- لایه ورودی (Input Layer): دادههای خام (پیکسلهای تصویر، کلمات متن) را دریافت میکند.

- لایههای پنهان (Hidden Layers): محل انجام محاسبات و یادگیری اصلی مدل هستند. این لایهها از طریق وزنها (Weights) به لایه بعدی متصل میشوند و با اعمال توابع فعالسازی، خروجیهایی را به لایه بعدی ارسال میکنند. تعداد زیاد این لایهها عامل اصلی عمق شبکه است.

- لایه خروجی (Output Layer): نتیجه نهایی پردازش شبکه را ارائه میدهد، مثلا طبقهای که تصویر به آن تعلق دارد یا کلمه بعدی در یک دنباله.

وزنها، سوگیریها و توابع فعالسازی

وزنها و سوگیریها: در فرآیند آموزش، وزنها مقادیر عددی هستند که قدرت ارتباط بین نورونها (سلولهای عصبی مصنوعی) در لایههای مختلف را نشان میدهند. سوگیریها نیز مقادیری هستند که به تنظیم آستانه فعالسازی نورون کمک میکنند و همانند یک ترم ثابت در معادله خط عمل میکنند. فرآیند آموزش در یادگیری عمیق، عملا تنظیم و بهینهسازی همین وزنها و سوگیریها برای کمینهسازی خطا است.

توابع فعالسازی: این توابع (مثلا ReLU، Sigmoid) پس از جمع وزنی ورودیها در هر نورون اعمال میشوند و غیرخطی بودن را به شبکه تزریق میکنند. این غیرخطی بودن برای یادگیری الگوهای پیچیده و غیرخطی در دادهها ضروری است.

الگوریتمهای کلیدی در یادگیری عمیق (Deep Learning)

انواع مختلف شبکههای عصبی عمیق برای انجام وظایف خاصی طراحی شدهاند:

شبکههای عصبی کانولوشنی (CNN)

این نوع شبکه عمدتا برای تحلیل دادههای شبکهای مانند تصاویر استفاده میشود. لایههای کانولوشن از فیلترهایی برای تشخیص الگوهای فضایی محلی (مثلا لبهها، بافتها) استفاده میکنند. CNNها پایه و اساس بینایی کامپیوتری (Computer Vision) مدرن هستند و برای آموزش مدلهای بزرگ آنها نیاز به منابع محاسباتی قوی است. فرآیند پرهزینه آموزش این مدلها، به ویژه برای حجم بالای داده، نیازمند دسترسی به یک سرور گرافیکی برای هوش مصنوعی با توان پردازشی موازی بالا است.

شبکههای عصبی بازگشتی (RNN و LSTM)

شبکههای عصبی بازگشتی (Recurrent Neural Networks) برای کار با دادههای دنبالهای (Sequential Data) مانند متن، صدا و سریهای زمانی طراحی شدهاند. RNNهای استاندارد در مدیریت وابستگیهای طولانیمدت (Long-Term Dependencies) دچار مشکل میشوند. از این رو، معماریهای پیشرفتهتری مانند حافظه طولانی کوتاه-مدت (Long Short-Term Memory یا LSTM) و واحد بازگشتی دروازهای (Gated Recurrent Unit یا GRU) توسعه یافتهاند که با استفاده از ساختارهای دروازهای (Gating Mechanisms) توانایی بهتری در حفظ اطلاعات در طول زمان دارند.

شبکههای مولد تخاصمی (GAN)

شبکههای مولد تخاصمی از دو شبکه رقیب – یک مولد (Generator) و یک متمایزکننده (Discriminator) – تشکیل شدهاند که در برابر یکدیگر آموزش میبینند. مولد سعی میکند دادههای جدید و واقعی تولید کند و متمایزکننده سعی میکند تشخیص دهد که داده ورودی واقعی است یا توسط مولد تولید شده است. GANها به ویژه در تولید تصاویر، ویدئوها و دادههای مصنوعی بسیار قدرتمند عمل میکنند.

مدلهای ترانسفورمر (Transformer Models)

مدلهای ترانسفورمر یکی از مهمترین پیشرفتها در زمینه یادگیری عمیق هستند که شیوه کار با دادههای دنبالهای، به ویژه در حوزه پردازش زبان طبیعی (NLP) را متحول کردهاند. معماری ترانسفورمر، که در سال ۲۰۱۷ با مقاله «توجه، تنها چیزی است که نیاز داری» (Attention Is All You Need) معرفی شد، به طور کامل شبکههای بازگشتی (RNN/LSTM) را کنار گذاشت.

به جای پردازش دنباله به صورت متوالی و قدم به قدم، ترانسفورمرها از مکانیزم توجه (Attention Mechanism) استفاده میکنند. این مکانیزم به مدل اجازه میدهد تا در یک دنباله، همبستگی و اهمیت هر کلمه یا بخش از ورودی را نسبت به سایر کلمات به طور همزمان محاسبه کند. این توانایی باعث میشود مدل درک بسیار عمیقتری از وابستگیهای دوربرد در متن پیدا کند.

از ترانسفورمرها معماریهای قدرتمندی مانند BERT (برای فهم زبان) و GPT (برای تولید زبان) متولد شدند که امروزه سنگ بنای هوش مصنوعی مولد (Generative AI) محسوب میشوند. این مدلها ابتدا بر روی حجم عظیمی از دادههای بدون برچسب (مانند کل اینترنت) آموزش میبینند و به عنوان مدلهای پایه (Foundation Models) شناخته میشوند.

این مدلهای پایه سپس میتوانند با استفاده از تکنیکهایی مانند تنظیم دقیق (Fine-tuning) به سرعت برای وظایف تخصصیتر مانند طبقهبندی متن، پاسخ به پرسش و ترجمه استفاده شوند. قدرت فوقالعاده ترانسفورمرها در تولید متن و کد شبیه به انسان، آنها را به ابزارهای محوری در توسعه هوش مصنوعی کنونی تبدیل کرده است. حجم عظیم محاسباتی مورد نیاز برای آموزش مدلهای ترانسفورمر بزرگ، بر اهمیت سرور گرافیکی برای هوش مصنوعی تاکید میکند تا فرآیند آموزش در یک زمان منطقی به اتمام برسد.

استفاده از مدلهای ترانسفورمر برای توسعه راهحلهای هوش مصنوعی، نه تنها نیازمند سختافزار پیشرفته برای فاز آموزش است، بلکه برای مرحله استنتاج (Inference) و سرویسدهی به کاربران نیز باید بهینهسازیهایی صورت پذیرد. برای این منظور، بسیاری از شرکتها به سمت استفاده از زیرساختهای مجازی با پردازندههای مرکزی قوی و بهینه روی میآورند. در چنین مواردی، استفاده از یک سرور ابری مقایس پذیر، میتواند تا حد زیادی هزینههای عملیاتی را کاهش دهد، در حالی که عملکرد قابل قبولی برای پاسخگویی به درخواستهای لحظهای کاربران فراهم میکند.

کاربردهای عملی یادگیری عمیق

یادگیری عمیق عملا هر صنعتی را که با حجم زیادی از داده سروکار دارد، تحت تاثیر قرار داده است:

- بینایی کامپیوتری (Computer Vision): تشخیص چهره، شناسایی اشیا در تصاویر و ویدئوها، خودروهای خودران.

- پردازش زبان طبیعی (NLP): ترجمه ماشینی، خلاصهسازی متن، چتباتها و دستیاران مجازی.

- سیستمهای توصیهگر (Recommender Systems): شخصیسازی پیشنهادات محصولات در پلتفرمهای تجارت الکترونیک یا محتوا در پلتفرمهای استریم.

- مراقبتهای بهداشتی و پزشکی: تشخیص بیماریها از روی تصاویر پزشکی (مانند اشعه ایکس و MRI) و کشف دارو.

- مالی و بانکداری: تشخیص تقلب و ارزیابی ریسک اعتباری.

نیازهای سختافزاری برای پیادهسازی یادگیری عمیق

یکی از مهمترین ملاحظات در پیادهسازی یادگیری عمیق، تامین زیرساخت سختافزاری مناسب است. به دلیل ماهیت محاسباتی سنگین عملیات ماتریسی (Matrix Operations) در شبکههای عصبی، واحدهای پردازش گرافیکی (GPUs) به استاندارد صنعتی برای آموزش مدلها تبدیل شدهاند. GPUها به دلیل معماری موازی خود، بسیار سریعتر از پردازندههای مرکزی (CPU) عمل میکنند.

اما همیشه نیاز به یک سرور فیزیکی گرانقیمت نیست. برای شروع کار، آزمایش ایدهها یا پیادهسازی مدلهای آموزش-دیده و سبک (Inference)، استفاده از منابع مجازی میتواند کفایت کند. در چنین شرایطی، تهیه یک سرور مجازی که دارای تعداد هستههای منطقی بالا و عملکرد قابل قبول باشد، یک راهحل اقتصادی و انعطافپذیر محسوب میشود. با این حال، برای پروژههای بزرگ مقیاس و آموزش مدلهای پایه (Foundation Models)، GPUها اجتنابناپذیرند.

چالشها و آینده یادگیری عمیق

با وجود موفقیتهای چشمگیر، یادگیری عمیق با چالشهایی نیز روبروست:

- نیاز به دادههای انبوه: آموزش مدلهای عمیق معمولا به مقادیر بسیار زیادی از دادههای برچسبگذاری شده نیاز دارد که جمعآوری و برچسبزنی آنها زمانبر و پرهزینه است.

- قابلیت تفسیر (Interpretability): مدلهای عمیق اغلب به عنوان «جعبه سیاه» شناخته میشوند. درک دقیق اینکه چرا یک مدل به خروجی خاصی رسیده است، خصوصا در حوزههای حساسی مانند پزشکی، یک چالش بزرگ است.

- مصرف انرژی: آموزش مدلهای بسیار بزرگ، انرژی زیادی مصرف میکند و تاثیرات زیستمحیطی قابل توجهی دارد.

آینده یادگیری عمیق بر روی مدلهای کمتر نیازمند داده (مانند یادگیری تقویتی)، بهبود قابلیت تفسیر و توسعه معماریهای کارآمدتر (مانند ترانسفورمرها) متمرکز خواهد بود که امکان استقرار آنها در دستگاههای کوچکتر (Edge Devices) را فراهم میآورد.

سوالات متداول

یادگیری عمیق (Deep Learning) یک زیرمجموعه از یادگیری ماشین است و یادگیری ماشین نیز خود یک زیرمجموعه از هوش مصنوعی (AI) به شمار میرود. به زبان ساده: هوش مصنوعی هدف کلی ایجاد سیستمهای هوشمند است. یادگیری ماشین روشی است برای رسیدن به این هدف (با استفاده از الگوریتمهایی که از داده یاد میگیرند). یادگیری عمیق (Deep Learning) روش پیشرفتهای در یادگیری ماشین است که از شبکههای عصبی عمیق (چند لایه) برای یادگیری خودکار ویژگیها استفاده میکند.

کلمه «عمیق» صرفا به تعداد لایههای پنهان (Hidden Layers) در معماری شبکه عصبی اشاره دارد. یک شبکه عصبی که بیش از دو یا سه لایه پنهان داشته باشد، معمولا به عنوان یک شبکه عمیق طبقهبندی میشود. این عمق به شبکه امکان میدهد تا سلسله مراتبی از مفاهیم را یاد بگیرد؛ از ویژگیهای ساده در لایههای ابتدایی تا مفاهیم بسیار پیچیده و انتزاعی در لایههای انتهایی.

سه نوع معماری اصلی که انقلاب یادگیری عمیق (Deep Learning) را رقم زدهاند عبارتند از:

- شبکههای عصبی کانولوشنی (CNN): که عمدتا برای پردازش تصاویر و وظایف بینایی کامپیوتری استفاده میشوند.

- شبکههای عصبی بازگشتی (RNN/LSTM): که برای کار با دادههای دنبالهای مانند متن و صدا طراحی شدهاند.

- ترانسفورمرها (Transformers): که پیشرفتهترین مدلها برای پردازش زبان طبیعی و هوش مصنوعی مولد هستند (مانند GPT و BERT).

یادگیری عمیق (Deep Learning)، به ویژه در فاز آموزش، نیازمند انجام حجم عظیمی از محاسبات ماتریسی و ضرب برداری است. واحدهای پردازش گرافیکی (GPU) دارای معماری موازی هستند؛ یعنی میتوانند هزاران محاسبه را به صورت همزمان انجام دهند. این قابلیت GPUها باعث میشود که آموزش مدلها بسیار سریعتر از زمانی انجام شود که با پردازندههای مرکزی معمولی (CPU) سروکار داریم.

خیر. اگرچه اکثر مدلهای موفق (مانند CNNها برای تشخیص تصویر) از یادگیری با نظارت (Supervised Learning) استفاده میکنند که به دادههای برچسبگذاری شده نیاز دارد، اما حوزههایی مانند یادگیری بدون نظارت (Unsupervised Learning) و یادگیری تقویتی (Reinforcement Learning) نیز وجود دارند. مهمترین مثال، مدلهای ترانسفورمر هستند که ابتدا با حجم عظیمی از دادههای بدون برچسب (مانند متن خام) به صورت خود-نظارتی (Self-Supervised) آموزش میبینند.

قابلیت تفسیر به این معناست که چقدر میتوانیم بفهمیم یک مدل یادگیری عمیق (Deep Learning) چرا به یک خروجی خاص رسیده است. از آنجا که مدلهای عمیق لایههای زیادی دارند، اغلب به عنوان «جعبه سیاه» شناخته میشوند و توضیح دادن دقیق فرآیند تصمیمگیری آنها دشوار است. بهبود قابلیت تفسیر یک چالش اساسی است، به ویژه در کاربردهایی که به اعتماد نیاز دارند (مانند تشخیص پزشکی یا تصمیمگیریهای مالی).

شما میتوانید دیدگاه خود را در مورد این مطلب با ما با اشتراک بگذارید.